在競賽中脫穎而出 - TIS工業相機贊助學生賽車團隊到達終點線

由 TIS Marketing 於 2022年2月7日 發表。

受到世界學生賽車(FSAE)啟發,清大賽車工廠NTHU Racing於2015年成立,從零開始,自行設計和製作賽車,參與FSAE Japan Japan,2018年轉型製作電動車,並於隔年勇奪電動車第二名成績,並獲得最佳電子系統設計、效率獎等獎項。近年來,自動駕駛車已成為汽車產業的一大趨勢。為求突破,清大學生團隊開始自行開發自駕賽車,The Imaging Source 兆鎂新 提供DFK 33UX273 相機以及相關配備,協助團隊達成目標。

定位及建立地圖資訊

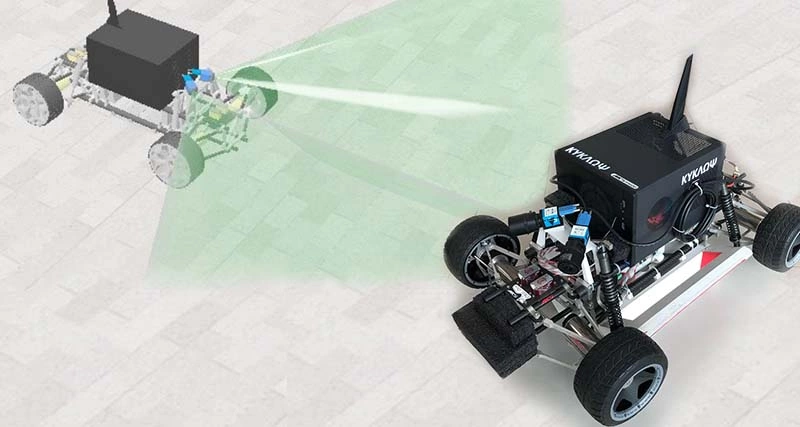

團隊先製作一台縮小版賽車(如下圖一)來測試硬體以及軟體設計,團隊目前開發之自駕系統由感測器融合與導航控制兩部分構成,由角錐定義之賽道實現對應的定位及導航系統,藉此驗證軟體架構的可行性。軟體驗證的方法融合了許多感測器類型的數據,如加速計、ToF以及視覺感測器。此感測器融合的過程可以達到最佳感測及導航控制。而視覺感測一直是無人車發展組成的一部分,用於可視化環境中的物體,如標誌和車道標記,視覺數據也可用於解決任何自動駕駛車面臨的另一個基本挑戰:確定自己在三維空間中的位置的能力。

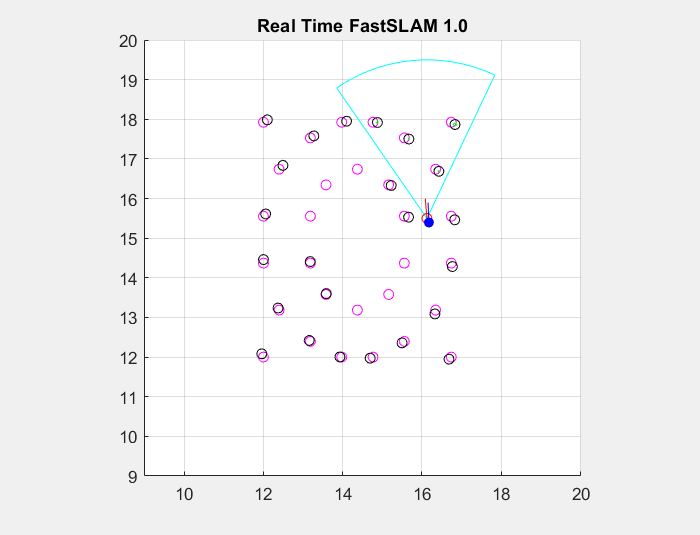

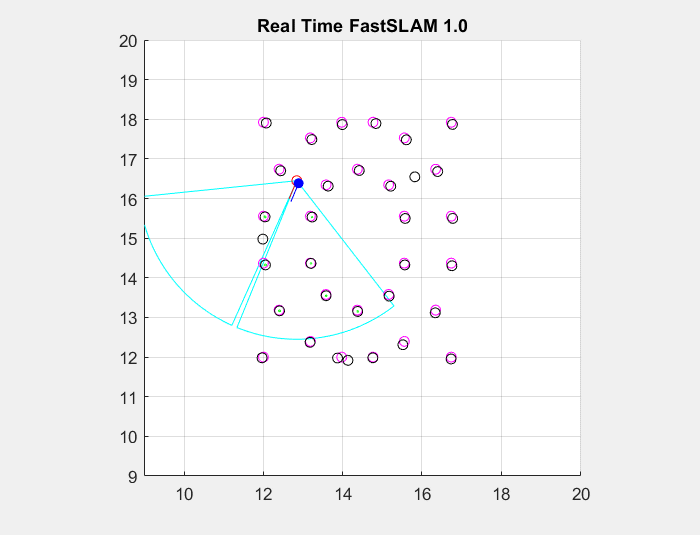

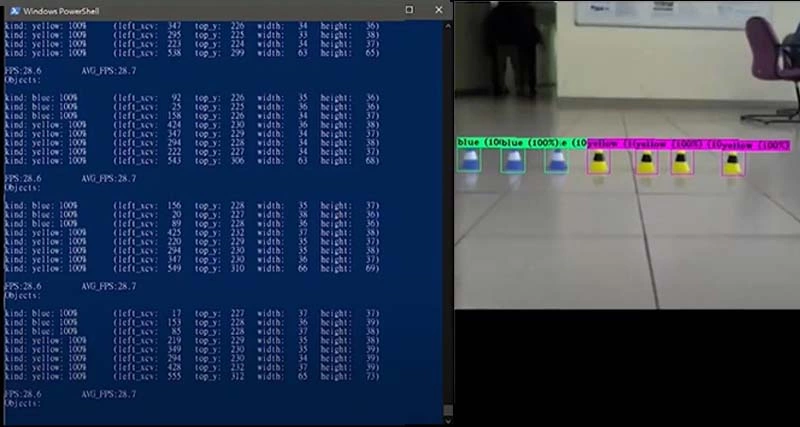

機器視覺辨識一直是自駕車不可或缺的一部分,有如無人車眼睛,幫助賽車在賽道上辨識且避開障礙,暢行無阻。一開始,學生安裝單台USB 3.0 DFK 33UX273工業相機,整合成一個單相機系統。相機的輸入被分析為環境資訊(例如黃色和藍色的角錐--下圖2),同時也用於幀對幀的視覺追蹤。相機的連續圖像被用來估計相機(車子自身)的即時位置變化,進行單眼視覺測距(VO),然後使用擴展卡爾曼濾波(EKF)和FastSLAM-1.0演算法,測量環境的基本結構和幾何形狀。 然後,這些特徵被匯總到一個視覺地圖中,以高精度的方式預估汽車的位置(同步定位和建立地圖資訊 --- SLAM)。

雙眼看得比單眼廣

在測試過程中,學生團隊發現單台相機系統所提供的視野(FoV)還是有點太窄了(下圖3a),過程中仍然有一些死角,無法完整辨認全數角錐。借鑒其他賽車隊的經驗,學生們決定測試在視覺系統中增加第二個相機,以增加視野並捕捉所有環境障礙物(圖3b)。 USB 3.0相機快速有效地連接到計算機,將圖像資訊從相機即時傳輸到資料庫。經過測試,雙相機系統便能成功辨識到所有角錐。